Miten datavirroista ammennetaan tietoa ja informaatiotulvaa hallitaan? Datan laskennallinen tulkinta on muovannut perinteisiä tutkimuskysymyksiä ja johtanut uusien tieteenalojen syntyyn. Datatieteen professori Leo Lahti pohtii luennollaan laskennallisen päättelyn luonnetta ja sen merkitystä tutkimuksessa ja yhteiskunnassa.

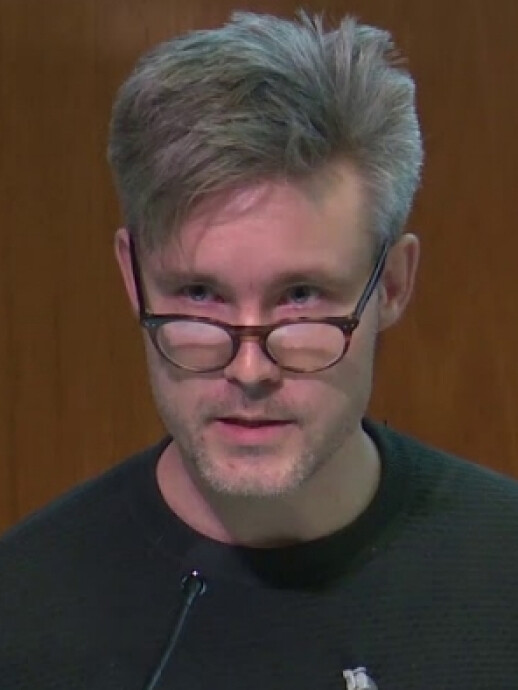

Leo Lahti piti professoriluentonsa 14.11. otsikolla "Kohinasta koherenssiin: datan ja laskennan merkitys nousevilla tutkimusaloilla".

Professoriluento tekstiversiona

Arvoisat kuulijat.

Systemaattinen havainnointi ja päättely ovat kaiken tutkimuksen perusta.

Se on kuitenkin usein työlästä ja sisältää aikaa vieviä mekaanisia vaiheita.

Lähes koko tunnetun historian ajan päättelyä onkin pyritty automatisoimaan.

Ensimmäinen historiankirjoituksen tuntema mekaaninen laskentaväline on Babyloniassa noin neljä ja puoli tuhatta vuotta sitten kehitetty sumerilainen helmitaulu. Keskiajalla Ramon Llull omisti suuren osan elämästään suunnitellakseen loogisia koneita, jotka voisivat perustavia filosofisia totuuksia yhdistelemällä johtaa kaiken mahdollisen tiedon. Jos tällainen kone olisi rakennettu, se olisi kuitenkin pystynyt ratkomaan vain tarkasti rajattua yksittäistä ongelmaa ja tulosten tulkintaankin tarvittiin ihmistä.

1800-luvulla merkittävä naistutkija Ada Lovelace suunnitteli joidenkin tulkintojen mukaan ensimmäisen tietokoneohjelman, vaikkei varsinaisia tietokoneita vielä ollutkaan rakennettu.

Ehkä vielä tätäkin tarkempana. pidän hänen huomiotaan, että uusi laskentateknologia voisi tarjota mekaanisen laskennan lisäksi uudenlaisia välineitä yhteistyölle ja siihen perustuvalle tutkimuskulttuurille.

Tässä hän näki pidemmälle kuin moni muu laskennan mekaniikkaan keskittynyt tutkija: päättelyn automatisointi ei ole pelkkää mekaniikkaa.

Uudet teknologiat ovat aina avanneet uusia tapoja havainnoida ja tutkia maailmaa. Rutiinien automatisointi vapauttaa aikaa luovalle ajattelulle ja uusien näkökulmien löytämiseen.

Avoimista laskentajärjestelmistä onkin muodostunut eräänlainen uusi röntgensäde, jonka avulla voimme läpivalaista datan anatomiaa ja syvärakennetta tai teleskooppi, joka auttaa muodostamaan kokonaiskuvaa korkeaulotteisista data-avaruuksista.

Viime vuosikymmeninä, erityisesti 50-luvulta alkaen tapahtui datatieteiden kannalta kaksi merkittävää käännettä: ammattitutkijoiden määrä lähti maailmansotien jälkeen nopeaan kasvuun ja samaan aikaan tapahtui harppauksia mittaustekniikoiden kehityksessä ja digitalisaatiossa ja datamassojen nopea karttuminen kiihtyi.

Samalla kasvoi tarve datan tehokkaalle tulkinnalle. Kun Berners-Lee CERNissä 90-luvun alussa päätti julkaista maailmanlaajuisen tietoverkon World Wide Webin kaikkien saataville. Ada Lovelacen visio laskentateknologioista uudenlaisena yhteistyön muotona lähti räjähdysmäiseen kasvuun. Yhtenä esimerkkinä tästä on vuosituhannen alussa ensimmäisen kerran valmistunut ihmisen perimän kartoitus, joka toteutui oletettua nopeammin, kun sekä genomidataa että algoritmeja jaettiin avoimesti tietoverkoissa. Samaan aikaan myös avoimen lähdekoodin laskenta-algoritmit alkoivat kohota valtavirtaan. Noihin aikoihin hyppäsin tähän sitten itsekin mukaan.

Koneellisesti havaintodata esitellään tai ajatellaan numeroina, mutta intuitiivisesti se on usein mielekkäämpää hahmottaa esimerkiksi suhteena, tekstinä, kuvina tai liikkeenä. Kun dataa kerätään, ajatellaan, että se sisältää informaatiota kiinnostuksen kohteena olevasta ilmiöstä. Suurempi määrä havaintoja voi tarjota täsmällisempää tietoa, laajempaa kokonaiskuvaa tai kykyä ennustaa tulevaa.

Siksi datankeraamisen kiinnitetään paljon huomiota.

Ajatellaan, että dataa keräämällä ja tutkimalla voisi olla mahdollista kompensoida puuttuvaa ymmärrystä. Suuri data tarkoittaa tietoaineistoja, jotka ovat niin valtavia, että tarvitaan vielä massiivisempia tietokoneita ja konesaleja sen hallintaan. Kun dataa on paljon, algoritmi voi huomata hyödyllisiä yhteyksiä asioitten välillä, sellaisia joita ihminen ei suoraan kykene näkemään. Tämä voi kuitenkin vaatia valtavasti konetehoa. Parempi ymmärrys ilmiöstä ja malleista auttaa karsimaan datan ja laskennan tarvetta. Tätä kehittämällä voitaisiin selvitä pienemmillä määrillä dataa, laskentaa, hiilidioksidipäästöjä ja elektroniikkaromua. Datatiede voikin tutkia myös niin sanottua vihreää laskentaa, joka pyrkii vähentämään datan ja laskennan ympäristökuormaa.

Voidaanko ilmastonmuutoksen ongelmia ratkaista tällaisessa kehikossa on toinen kysymys, mutta tehokkuudella ja nopeudella on muutakin arvoa.

Dataa yhdistelemällä saadaan helposti rakennetuksi kokonaisuuksia, joita ei niiden laatijakaan aina tunnu hallitsevan.

Tosiasia on kuitenkin se, että datan määrästä huolimatta se yleensä kuvaa vain pientä osaa kiinnostuksen kohteena olevasta ilmiöstä ja sitäkin puutteellisesti ja epätarkasti. Tämä on tutkimuksen haasteena toki yleensäkin.

Luonnolliset ja yhteiskunnalliset ilmiöt ovat monimutkaisia, ja tällä tavalla ajateltuna kaikki data on pientä suhteessa tutkimuksen kohteena oleviin rikkaisiin ilmiöihin.

Vaikka viime aikoina on puhuttu suuresta datasta, paljon useammin dataa onkin saatavilla hyvin niukasti. Data voi olla kohinaista, epätarkkaa, puutteellista tai hankalasti hyödynnettävää.

Yksi tärkeä datatieteen tutkimuskohde onkin ymmärtää, miten hyvin pienestä määrästä havaintoja voitaisiin saada irti mahdollisimman paljon hyödyllistä informaatiota. Jo yksikin havainto voi olla ratkaiseva, jos meillä on muuta taustatietoa ja perusteltuja oletuksia.

Kun havaintoja on rajallisesti, korostuu ennakkotiedon hyödyntäminen ja epävarmuuksien esittäminen.

Moni luottaa mittausten voimaan, mutta on hyvä pitää mielessä, ettei data ole objektiivista.

Datan keruu ja tutkimus tekee väistämättä oletuksia siitä, minkälainen data on relevanttia ja minkälaista kertomusta datan avulla rakennetaan. Signaalin erottaminen kohinasta vaatii oletuksia ja malleja. Datasta on mahdotonta tehdä mielekkäitä tulkintoja turvautumatta jonkinlaiseen ennakoivaan teoreettiseen kontekstiin, joka voi perustua aiempaan dataan ja niin edelleen.

Toisaalta tieto rakentuu tällaisten vihjeiden ja arvausten kautta. Datalla voi olla merkittävä tehtävä vihjeiden tarjoamisessa, kun data on niukkaa ja ilmiöt monimutkaisia.

Ajatellaan vaikkapa kirjapainotoiminnan leviämistä Euroopassa uudella ajalla tai mikrobikirjon vaihtelua suomalaisväestössä, joita me olemme tutkineet. Tällaisten ilmiöiden kompleksisuus pakenee valmiita mekanistisia malleja. Silti niissä ilmeneviä säännönmukaisuuksia voidaan kuvata ja esittää laskennallisesti.

Yli puoli vuosisataa sitten, vuonna 1962, John Tukey tutki peräänkuulutti klassikkojulkaisussaan “The Future of Data Analysis” tarvetta akateemisen tilastotieteen uudistamiselle ja nosti vielä esiin tuolloin nimeämättömän empiirisen tutkimusalan, joka oppisi datasta.

Hän painotti sitä, että riittämätön evidenssi voi auttaa osoittamaan oikean ratkaisun suunnan ja muistutti, että summittainen vastaus oikeaan kysymykseen on arvokkaampi kuin tarkka vastaus väärään kysymykseen. Tälle uudelle tieteelle olisi ominaista, että loogista argumentaatiota ei niinkään käytettäisi päätelmien todistamiseen, vaan enemmänkin niiden pätevyyden arviointiin datan tulkinnassa.

Data-analyysi pyrkisi käyttökelpoisuuteen enemmän kuin lopulliseen varmuuteen. Uusi tiede painottaisi teorian sijaan data-analyysin empiiristä puolta.

Hauskana yksityiskohtana mainittakoon, että Tukey jopa vertasi data-analyysin opettamista biokemian opettamiseen.

Datatieteessä laboratoriotekniikat korvataan laskentateknologioilla. Johtopäätösten sijaan korostuu vihjeiden haku ja loogisen todistamisen sijasta havainnot, havainnoista ammentavat perustelut.

Alettiin korostaa datan keräämisen, käsittelyn esittämisen ja tulkintateknologioiden merkitystä.

Todellisista ilmiöistä kumpuavan datan tulkintaan tarvittaisiin siten paljon muutakin kuin perinteisen tilastotieteen teoreettisia malleja.

Voidaankin ajatella, että datatieteen erikoisaloihin kuuluvat tilastotiede, sovellettu matematiikka ja koneoppiminen kehittävät näihin ongelmiin omia erityisratkaisujaan, mutta samalla näihin liittyvät teknologiset innovaatiot laskennan automatisoinnista, skaalaamisesta ja avoimuudesta ovat nostaneet merkitystään nykytieteissä. Meillä Suomessakin on vuosikymmenten kotimainen tutkimusperinne, joka on korostanut tietotekniikan merkitystä datan tulkinnassa. Tällä vuosituhannella laskennan automatisoinnista on edetty laskennan avaamiseen.

Informaatioteknologioiden ja viestintäkulttuurin murrokset ovat muovanneet tieteen kehitystä koko historian ajan. Kun tiedonvälitys vilkastui, kehittyi yhä järjestelmällisempiä tapoja kerätä, järjestää, tallentaa, analysoida ja visualisoida ja tulkinta havaintoja. Uutta tietoa voitiin kartuttaa tehokkaammin ja sen pätevyyttä voitiin koetella perusteellisemmin. Tiedosta tuli yhteisöllisempää ja sen hyödyntämiseen löytyi nopeammin uusia tapoja. Datatieteessä korostuukin sellaisia näkökulmia kuin tulkinnan läpinäkyvyys, toistettavuus jaettavuus ja uudelleenkäytettävyys. Nämä ovat toki tutkimuksen perinteisiä ideaaleja, mutta niiden toteutumisesta on tullut yhä hankalampaa, kun data ja sen tulkinta monimutkaistuvat.

On tunnettua, että tutkijat voivat päätyä samankin aineiston pohjalta hyvin erilaisiin johtopäätöksiin. Juuri sen vuoksi läpinäkyvyydestä ja toistettavuudesta puhutaan nykytieteessä niin paljon.

Vaikka avoimuus tutkimuksessa on kasvanut esimerkiksi päätöksenteoksi toimitettujen asiantuntijalausuntojen taustalla olevista algoritmeista on ollut yhä hankala saada tietoa. Asia on tullut omakohtaisestikin tutuksi, kun olen avustanut kotimaisia järjestöjä tähän liittyvien tietopyyntöjen laadinnassa. Kun tutkija esittää asiantuntija-arvioita, ei pelkkä asiantuntijan auktoriteetti riitä, vaan on tärkeä tietää, mihin päättely perustuu. Näin on muuten myös Oikeuskansleri edellisvuonna todennut lausunnossaan.

Francis Galton, jota voitaisiin myös pitää alan eräänlaisena pioneerina, pohtii jo vuonna 1901 Biometrika-lehden ensimmäisessä numerossa, että tutkijoiden olisi syytä jakaa aineistonsa julkisesti. Informaatiotekniikka on mahdollistanut uuden avoimuuteen perustuvan tutkimuskulttuurin ja viitatuimpien tieteellisten julkaisujen joukossa onkin huomattavan paljon datatieteen menetelmiä, jotka rakentavat siltaa teoreettisten mallien ja empiiristen sovellusten välillä.

Olemme todistaneet kokonaan uusien tieteenalojen nousua, kun aiemmat tutkimusperinteet ovat törmänneet uusiin datan ja laskennan luomiin mahdollisuuksiin. Laskenta- ja visualisointiteknologiat, jatkuvasti kasvava datan määrä, ja määrällisen tutkimuksen leviäminen yhä useammille sovellusaloille ovat ajaneet tätä kehitystä niin humanistisissa, yhteiskunnallisissa, luonnontieteissä kuin tekniikassakin.

Laskentateknologioiden kehitys on johtanut uudenlaisen tutkimuskulttuurin ja yhteistyömuotojen syntyyn. Datatiede on osa tätä jatkumoa. Se korostaa päättelymenetelmien automatisointia. Se vapauttaa aikaa tutkimuksen syventämiseen ja helpottaa tulkintamenetelmien systemaattista vertailua ja parantamista.

Data-analyysin kehittämisestä voidaan tehdä empiiristä tiedettä, jossa digitaalisten resurssien avoin jakaminen ja kehittely on keskeistä.

Aiemman tiedon julkinen kritiikki ja sen päälle rakentaminen ovat tieteen kovinta ydintä.

On arvioitu, että julkisuus kiihdytti modernin tieteen eriytymistä alkemiasta uudella ajalla. Tulkinnan läpinäkyvyys on tärkeää myös nyt, jotta datan tulkinnasta ei muodostu tämän päivän salatiedettä. Mutta kyse ei ole pelkästä läpinäkyvyydestä. Yhtä tärkeää on jo Ada Lovelacen ennustamat avoimet yhteistyömuodot, jotka läpinäkyvyys ja uusi teknologia mahdollistaa.

Datatieteen nousu on vastannut tähän tarpeeseen. Datatiede keskittyy informaation löytämiseen ja esittämiseen todellisissa, soveltuvissa tilanteissa.

Ymmärrys laskentatekniikoiden käyttäytymisestä idealisoiduissa tilanteissa on arvokasta, mutta sitä tulee täydentää kokemusperäisellä tiedolla todellisista tilanteista. Edistys vaatii toikin sanoin, että epätodellisten oletusten, mielivaltaisten kriteereiden ja abstraktien tulosten ohella olemme valmiita rohkeasti kohtaamaan sovellusalojen ongelmat ja data-analyysin empiiriset haasteet ja tekemään tästä uutta tiedettä.

Keskeisimmät tutkimusaiheet ja asiantuntijuusalueet

- data-analyysi

- koneoppiminen

- laskennallinen tiede

- laskennalliset ihmistieteet

Luonnolliset ja yhteiskunnalliset järjestelmät ovat monimuotoisia ja pakenevat usein valmiita malleja. Oppivia algoritmeja ja ennakkotietoa hyödyntämällä monimuotoisesta havaintodatasta voidaan seuloa merkityksellistä tietoa, joka ei istu valmiisiin malleihin; näin tutkittavista ilmiöistä voidaan saavuttaa esimerkiksi rikkaampaa tulkintaa ja tarkempia ennusteita. Lahden tutkimusryhmä kehittää uusia tapoja datavirtoihin sisältyvän informaation tunnistamiseen ja tulkintaan.

Tutkinnot ja dosentuurit

tekniikan tohtori, Aalto-yliopisto 2010